全球人工智慧生態系統正在經歷重大變革,因為公司尋求更快、更高效和更具成本效益的方法來訓練大規模模型。多年来,Nvidia的GPU一直是現代人工智慧發展的支柱,驅動著從早期的大型語言模型到先進的研究實驗室的所有事物。

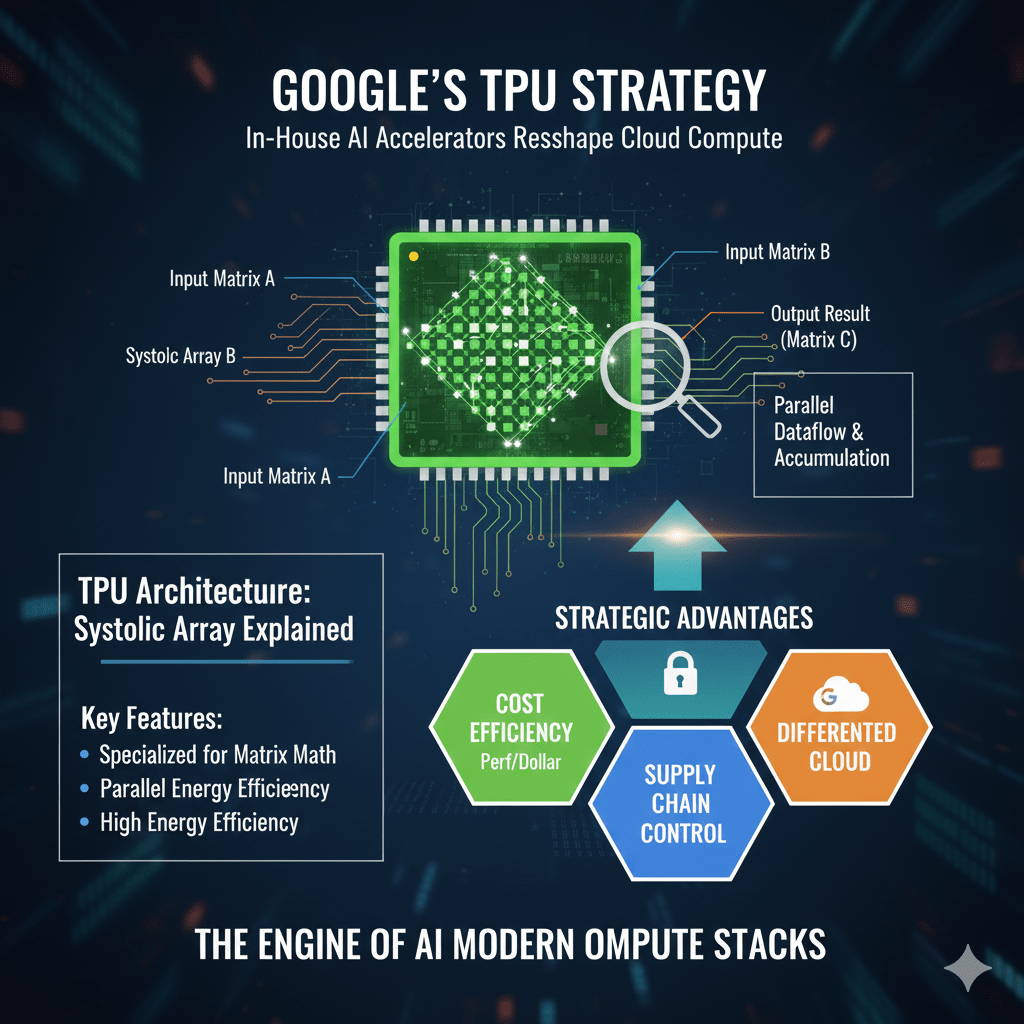

但最近,市場的注意力轉向了一個不同的趨勢:內部人工智慧加速器的興起——特別是谷歌的張量處理單元(TPUs)。

Alphabet在專用人工智慧硬體上的持續投資,加上日益增長的雲基礎設施需求,使谷歌在人工智慧計算的未來中成為了一個關鍵角色。這一變化現在正引起分析師、開發人員和長期投資者的注意。

---

🔍 為什麼谷歌的 TPU 策略引起了關注

谷歌已經花費了近十年的時間來建造專門為 AI 工作負載設計的自定義芯片。隨著每一代 TPU 的推出,重點一直放在:

降低訓練成本

更高的能源效率

可擴展的雲部署

減少對外部芯片供應商的依賴

最近有關新 TPU 架構和訓練優化的公告引發了討論,雲供應商可能會開始混合 - 或甚至優先考慮 - 自己的加速器而非第三方硬體。

這種多樣化減少了對單一供應商的依賴,這在 AI 行業中已經成為一個日益嚴重的擔憂。

---

🏭 雲供應商正朝著擁有自己的計算堆棧邁進

隨著 AI 模型變得越來越大且計算成本越來越高,對硬體的控制成為競爭優勢。

塑造這一轉變的趨勢包括:

1. 成本效益

訓練先進模型需要大量計算。

使用內部加速器的雲供應商可以在規模上優化每美元的性能。

2. 供應鏈穩定性

擁有硬體減少了對短缺、瓶頸或價格波動的脆弱性。

3. 差異化的雲服務

硬體獨佔性使得像 Google Cloud、AWS 和 Azure 這樣的平台能夠提供獨特的 AI 訓練環境。

4. 行業採用增長

一些 AI 實驗室和企業已經開始嘗試使用 TPU 和其他加速器來多樣化其計算堆棧。

---

📈 投資者的興趣反映了長期基礎設施主題

機構投資者對像 Alphabet 這樣的公司的投資增加,促進了市場的討論。這些決策通常涉及:

對雲增長的長期信念

對 AI 基礎設施投資的信心

對建立“全棧”AI 平台的公司的戰略興趣

雖然一項投資並不能定義行業趨勢,但它與全球向自定義 AI 芯片開發的更廣泛運動一致。

---

🧭 這對 AI 計算的未來意味著什麼

AI 硬體生態不再是一個單一參與者的領域。相反,生態系統正在演變為一種多平台架構,其中 GPU、TPU 和自定義加速器共存。

需要關注的關鍵因素:

主要 AI 實驗室如何分配未來的計算預算

基於 TPU 的訓練採用增長

雲供應商擴展其芯片路線圖

具有競爭力的定價和性能基準

對 AI 基礎設施提供者的影響

AI 發展的下一階段將不僅由算法和模型來定義 - 還將由驅動它們的芯片來定義。

---

📝 免責聲明

這篇文章僅用於信息和教育目的。它不構成財務建議或購買或出售任何資產的推薦。所有提到的公司和代幣均中立地參考。

在做出投資決策之前,始終進行自己的研究。

提到的代幣: $MMT (僅提及 - 不是背書.)

#MMT #artificialintelligence #AIRevolution #BinanceFeed #CryptoCommunitys