OpenLedger es una cadena de bloques orientada a la IA (una segunda capa de Ethereum basada en OP Stack), cuyo núcleo no es "correr puntajes", sino crear un ciclo cerrado de conjuntos de datos (Datanets) — modelos (ModelFactory / OpenLoRA) — llamadas de inferencia — distribución de beneficios y gobernanza: quién contribuye con qué datos, qué inferencia ha afectado, cuánto se recibe de tarifas de inferencia, todo es rastreable, calculable y gobernable. OPEN es tanto Gas como un incentivo de atribución y un token de gobernanza. La red principal y el token se lanzarán públicamente en septiembre de 2025, con una circulación inicial del 21.55% (215.5 millones / un total de mil millones), y se incorporarán funciones como "recompensas por atribución", "pago por uso" y "votación de gobernanza" en el marco institucional.@OpenLedger #OpenLedger

OpenLedger es una cadena de bloques orientada a la IA (una segunda capa de Ethereum basada en OP Stack), cuyo núcleo no es "correr puntajes", sino crear un ciclo cerrado de conjuntos de datos (Datanets) — modelos (ModelFactory / OpenLoRA) — llamadas de inferencia — distribución de beneficios y gobernanza: quién contribuye con qué datos, qué inferencia ha afectado, cuánto se recibe de tarifas de inferencia, todo es rastreable, calculable y gobernable. OPEN es tanto Gas como un incentivo de atribución y un token de gobernanza. La red principal y el token se lanzarán públicamente en septiembre de 2025, con una circulación inicial del 21.55% (215.5 millones / un total de mil millones), y se incorporarán funciones como "recompensas por atribución", "pago por uso" y "votación de gobernanza" en el marco institucional.@OpenLedger #OpenLedger

1) El problema no es "quién tiene el modelo más grande", sino "cómo se distribuye correctamente el valor".

El problema estructural de la industria de IA tradicional radica en que el flujo de valor entre datos y modelos es invisible: los datos provienen en gran medida de la "caja negra" de la plataforma, el uso de modelos es monopolizado por la plataforma, y los contribuyentes tienen dificultad para distribuir beneficios según su "real impacto". La respuesta de OpenLedger son tres cosas:

Registro en la cadena: Registrar conjuntos de datos, modelos, adaptadores, agentes, etc., como ciudadanos de primera clase en la cadena (la cadena objetivo es OpenLedger, con liquidación en Ethereum), cada entrenamiento, publicación, llamada se contabiliza, garantizando auditabilidad y trazabilidad.

Prueba de atribución (Proof of Attribution, PoA): En la capa de inferencia, se identifican "qué fragmentos de datos influyeron en esta salida", y los costos de inferencia se distribuyen a los contribuyentes correspondientes según su impacto; el algoritmo de atribución utiliza métodos de gradiente para modelos pequeños y técnicas como arreglos sufijos para modelos grandes, logrando una distribución a nivel de inferencia.

Facturación bajo demanda (Modo Pull): Quien activa una inferencia/llamada, paga; los costos se liquidan en la cadena y se dirigen a los autores del modelo y a los contribuyentes de datos, formando un ciclo cerrado de "uso-pago-incentivo-calidad".

Esto significa: cada respuesta de IA es una ruta de distribución de valor verificable. No es un black box dictado por la plataforma.

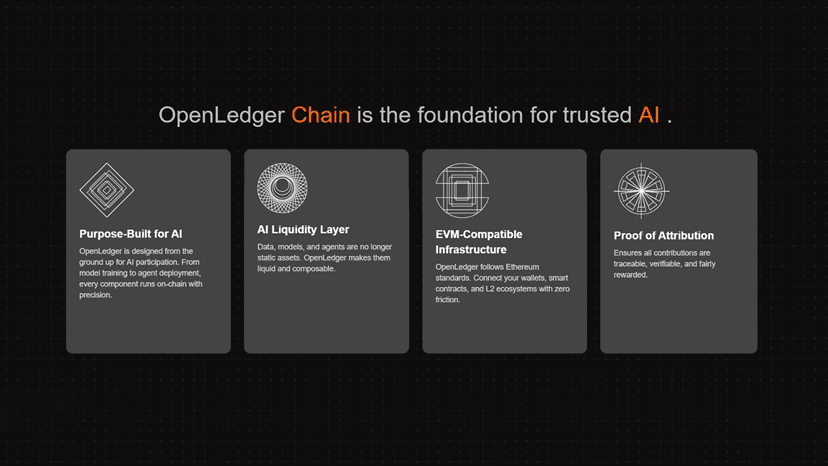

2) Base tecnológica: OP Stack L2 + registro en la cadena + atribución comprobable.

El stack tecnológico de OpenLedger es compatible con EVM y ha realizado personalizaciones institucionales para AI:

Liquidación y seguridad: Como L2 de Optimistic Rollup (OP Stack), el orden y la presentación de transacciones por lotes regresan a la cadena principal de Ethereum, heredando la seguridad y la finalización de la cadena principal.

Registros en la cadena (On-Chain Registries): Establecer índices y metadatos inalterables para modelos, adaptadores LoRA, conjuntos de datos, agentes, etc.; cualquier nueva versión/nuevo adaptador se registra en la cadena mediante transacciones, convirtiéndose en una "lista de materiales de software" (SBOM) auditable.

Motor de atribución: Hacer atribución a nivel de inferencia utilizando diferentes pilas tecnológicas en modelos de diferentes escalas: modelos pequeños pueden hacer estimaciones de impacto a nivel de gradiente, y modelos grandes pueden utilizar técnicas de coincidencia de texto/secuencia como arreglos sufijos, asegurando que se aterrice "cuota de impacto" en el camino de inferencia. Esto no es "distribución a ciegas", sino convertir la atribución en un proceso programático verificable.

Puntos clave: OpenLedger no se trata de lanzar cálculos costosos en todas las cadenas repetidamente, sino de congregar/indexar/aterrizar la atribución dentro de la capa institucional de esta cadena, reducir costos mediante escritura bajo demanda, y utilizar la capa de liquidación de Ethereum como "ancla final".

3) Lado de datos: Datanets fija las reglas de "contribución de datos-acceso-distribución".

Datanets es una red de datos descentralizada que opera por unidades de datos en el dominio: Quién contribuyó con qué, cuándo pasó por qué proceso de verificación, y en qué entrenamiento de modelo entró, todo queda registrado en la cadena. Una vez que un modelo es determinado como "afectado por esos datos" durante la inferencia, el contribuyente de datos correspondiente puede recibir la distribución de OPEN. Para los organizadores de datos, Datanet es tanto un "DAO de datos" como un contenedor para la ejecución de estrategias de privacidad/ cumplimiento (listas blancas, acceso por permisos, rastreo de auditoría, etc.), que puede servir a sectores verticales como salud, mapas, mercados DeFi, sensores IoT, etc.

Comparado con los mercados de datos tradicionales: Web2 suele vender datos empaquetados solo una vez; OpenLedger permite que cada llamada de modelo a lo largo del ciclo de vida de los datos "cargue electricidad", convirtiendo los datos en "activos de dividendos". Esta es la clave para un "suministro de datos sostenible".

4) Lado del modelo: ModelFactory + OpenLoRA, reduciendo el costo de despliegue "de mil modelos a mil caras" al mínimo.

ModelFactory proporciona a desarrolladores y usuarios no técnicos un conjunto de estaciones de trabajo GUI: desde elegir Datanet, iniciar ajustes finos, registrar metadatos, hasta publicación, facturación y propuestas de gobernanza, todo el proceso "sin línea de comandos". Todos los productos (pesos base/adaptadores/versiones) están registrados en la cadena.

OpenLoRA se centra en el costo de inferencia: una vez que la GPU soporta miles de adaptadores LoRA dinámicamente enchufables (JIT Adapter Loading), combinando paralelismo de tensores, Flash-Attn, Paged Attn y cuantificación, llevando a los límites el triángulo de throughput/retraso/costo, adecuado para aplicaciones de cola larga "modelos pequeños de múltiples dominios y cambios frecuentes". En una frase: transformar el "servicio de múltiples modelos" de una expansión horizontal a una programación granular en la capa de adaptadores.

La combinación de estas dos cosas ha permitido que "la activación de modelos" tenga realmente un punto de apoyo ingenieril: publicación→ atribución→ distribución por llamada, y el despliegue puede escalarse a un costo marginal extremadamente bajo.

5) Lado del agente: de "hablar" a "liquidar" como un autónomo.

El AI Studio de OpenLedger/Open Chat permite a los desarrolladores registrar agentes como objetos en la cadena: quién es el agente, de qué modelos/adaptadores depende, cómo se liquidan cada vez que se llama, cómo se retroceden las llamadas fallidas, todo tiene un proceso claro. Lo más importante es que cada acción del agente es un "evento contabilizable", el usuario paga OPEN para activar la inferencia, y los costos se distribuyen a lo largo del camino "Agente-modelo-datos". En el escenario de billetera (como la exploración de integración con Trust Wallet), el agente puede convertirse en una "billetera de lenguaje natural", y debido a la "atribución + registro", su límite de seguridad puede ser gobernado y auditado.

6) Economía: Las cuatro líneas principales de OPEN = combustible de transacciones + recompensas por atribución + seguridad de staking + gobernanza.

La investigación de Binance lo resume de manera clara: OPEN es el Gas de la red, así como la recompensa de atribución, pago y liquidación, y la unidad central de gobernanza. Las tarifas de inferencia son pagadas por los usuarios según demanda; las recompensas de PoA dirigen el flujo de caja de las llamadas a los contribuyentes de datos/modelos; el staking y la gobernanza permiten a los participantes a largo plazo "tener piel en el juego", votando sobre parámetros, actualizaciones y distribución de recursos. Suministro de tokens: Total de 1 mil millones, con una circulación de 215.5 millones (21.55%) al momento del lanzamiento, el resto se asigna entre comunidad, equipo, inversores, ecosistema, etc., con planes de bloqueo/desbloqueo lineales (comúnmente 12 meses cliff + 36 meses lineales, sujeto a divulgación oficial).

La clave no es el eslogan, sino que el flujo de caja es medible: Cuando el feedback positivo de "aumento de llamadas de inferencia↑→ aumento de costos↑→ aumento de recompensas por atribución↑→ aumento de suministro de datos y modelos↑→ más llamadas" se manifiesta, la demanda de uso de OPEN y el valor del poder de gobernanza se fortalecerán juntos.

7) Diferencias con el "mercado de IA/cadena de poder de cálculo": OpenLedger lleva "dinero a la frontera de contribución".

No se trata solo de vender "tiempo de cálculo": las redes de poder de cálculo generalmente cobran por tiempo/tarea, sin prestar atención a "quién contribuyó con datos/adaptadores clave"; OpenLedger distribuye el dinero de manera precisa según el impacto, recompensando los factores que "pueden mejorar la calidad de salida".

No se trata solo de hacer un "catálogo de modelos": El mercado de modelos a menudo se queda en la etapa de listado/suscripción; OpenLedger vincula la liquidación a nivel de inferencia, registros en la cadena, gobernanza y facturación bajo demanda: cada respuesta es un evento de distribución.

No es "trasladar la factura de Web2 a la cadena": Muchas de las llamadas "facturación en la cadena" siguen siendo libros de cuentas de plataformas; OpenLedger registra en la cadena el origen, la versión, la llamada y la distribución, que pueden ser auditados y recalculados por terceros.

8) Ecosistema y colaboración: desde universidades hasta billeteras, luego a sectores verticales.

Los documentos oficiales y de investigación indican: OpenLedger está avanzando en la integración del ecosistema junto a Blockchain en Berkeley, Trust Wallet, entre otros; al mismo tiempo, se está trabajando con la red de sensores ambientales Ambios y el equipo médico LLM Balkeum Labs en la integración de modelos y datos verticales, intentando validar el mecanismo de "atribución + distribución" en datos reales y aplicaciones reales. Si el agente de lenguaje natural en la billetera se implementa, se validará directamente la disponibilidad y retención de "facturación bajo demanda para el cliente final".

9) Lista de verificación para desarrolladores: escribir "economía programable" en código.

(1) Tratar la "atribución" como un parámetro en lugar de un adorno. La interfaz de inferencia debe devolver la huella y la porción de distribución del modelo/datos; tu backend/contrato debe realizar la distribución secundaria o descuentos según la factura de atribución, no solo tomar "el texto del resultado".

(2) Facturación bajo demanda y lógica de reintento. Basándose en "quien activa, quien paga", aclarar estrategias de respaldo para reintentos fallidos/rollback por tiempo de espera y "respuesta no cobrable", evitando así la generación de deudas incobrables en períodos de alta demanda.

(3) Gobernanza de versiones de modelos y adaptadores. Forzar la versionado en el registro, escribiendo procesos combinables de "rollback-congelar-actualizar"; en caso de salidas anómalas, poder congelar la versión correspondiente y redirigir el tráfico con un solo clic.

(4) Costos/beneficios auto-consistentes. Conectar el costo de cada llamada (Gas + tarifa de inferencia) y los ingresos (suscripción/pago por uso), y si es necesario, hacer sugerencias de "retraso + costo" en el frontend, permitiendo que el usuario elija entre el camino "rápido/económico".

10) Marco de investigación e inversión: observar "uso-flujo de caja-suministro-gobernanza".

Crear un tablero semanal para rastrear fundamentos en lugar de discutir el precio del token:

Uso: Volumen de llamadas de inferencia en la red principal, número de agentes/modelos activos y número de Datanets activos; observar si presenta una "curva de uso diario" (días laborales superiores a fines de semana).

Flujo de caja: Total de tarifas de inferencia/promedio de tarifa única y proporción de distribución PoA, así como retención neta de desarrolladores/lado de datos.

Lado de suministro: Tasa de aumento de nuevos modelos/adaptadores en la cadena y tasa de cobertura de atribución (cuántas llamadas fueron exitosamente atribuidas y distribuidas).

Curva de gobernanza: Total de staking, promedio de períodos de bloqueo, tasa de participación en votación y retraso en la ejecución de "propuestas de parámetros/actualización".

Cuando "uso↑→ flujo de caja↑→ entrada neta del lado de suministro↑" resuena con "la curva de gobernanza se alarga (boleta a largo plazo)" es cuando el punto de valoración de OPEN se considera estable.

11) Riesgo e incertidumbre: La institución es muy "bonita", pero la ejecución debe ser "firme".

Corrección de atribución: ¿son estables los métodos de gradiente/arreglos sufijos y similares en modelos grandes y multimodales? ¿Pueden muestras adversarias/contaminación de datos desviar la distribución? Se necesita una cadena de herramientas de verificación de terceros abierta y muestreo aleatorio.

Ejecución y UX: La facturación bajo demanda debe ser imperceptible, de lo contrario, bloqueará a los usuarios; si la integración del lado de billetera no es fluida, la penetración del cliente final se desacelerará.

Ritmo de desbloqueo y suministro: En la etapa inicial de lanzamiento, la circulación ~21.55%; si el desbloqueo de la comunidad/equipo/inversores no coincide con el uso real, la volatilidad secundaria se amplificará. Combinar el calendario de desbloqueo con el flujo de caja de llamadas.

Externalidades de cumplimiento: En datos involucrando salud/finanzas, la autorización/anónimización de Datanet y el cumplimiento de datos transfronterizos deben tener herramientas institucionalizadas, de lo contrario, será difícil concretar colaboraciones significativas.

12) Una frase de cierre

La esencia de OpenLedger radica en "programar la economía de la IA": datos, modelos y agentes son activos en la cadena; cada inferencia es un evento cobrable, atribuible y auditado; OPEN permite que el valor fluya automáticamente a lo largo del camino "quien contribuye-quien impacta-quien recibe dinero". Si la curva de llamadas y la curva de distribución de PoA pueden seguir subiendo, el valor intrínseco de OPEN será tasado por "flujo de caja" y no por "emociones"; de lo contrario, incluso la narrativa más atractiva no será más que un cartel.

Lecturas referenciales y extendidas

Investigación de Binance: Posicionamiento del proyecto, mecanismo PoA, tecnología OP Stack L2, funciones y suministro de OPEN, panorama de cooperación.

Documentación oficial: Documentos y interfaces de desarrollo sobre Datanets, Proof of Attribution, ModelFactory, OpenLoRA, etc.

Academia Phemex: Suministro total de 1 mil millones, circulación inicial de aproximadamente 21.55%, ritmo de bloqueo y pertenencia, interpretación de arquitecturas OP Stack + (frecuentemente combinado con EigenDA) y la idea de "IA Pagable".

CMC AI/Últimas noticias: Proporción de circulación y punto de desbloqueo inicial, rumores sobre integración de billeteras y discusión sobre el umbral de uso, utilizados para evaluar señales externas de "accesibilidad al cliente final".